Szakmai útmutató vállalkozóknak és marketing vezetőknek

A keresőoptimalizálás évek óta állandóan változó terület, de mára már eljutottunk oda, hogy a klasszikus SEO mellé felzárkózott egy új dimenzió:

Ez pedig nem más, mint az AI válaszoptimalizálás, vagyis annak biztosítása, hogy a mesterséges intelligencia rendszerek – Google AI Mode, ChatGPT, Perplexity, Gemini, Bing AI – a te tartalmadat használják fel válaszaikhoz.

Azok a vállalkozások, akik csak a klasszikus SEO-ban gondolkodnak, már most hátrányból indulnak. A weboldalak nagy része még mindig a régi logika szerint épül, miközben a generatív keresés olyan mértékben alakítja át a felhasználói viselkedést, amit érdemes komolyan venni.

Ebben az átfogó cikkben bemutatom:

– milyen mérések bizonyítják legjobban a keresőoptimalizálás megtérülését,

– hogyan optimalizálok egy weboldalt az AI válaszgenerálás logikájára,

– milyen technikai SEO hibákat látok leggyakrabban,

– miért kulcsfontosságú a megfelelő weboldal tárhely,

– hogyan kezelem a migrációkat lépésről lépésre,

– hogyan végzek versenytárselemzést, kulcsszóstratégiát és Core Web Vitals fejlesztést.

A cikk minden eleme gyakorlati tapasztalatra épül (2025-2026), azokra a helyzetekre, amelyekkel nap mint nap találkozom vállalkozókkal és cégtulajdonosokkal együtt dolgozva.

1. Hogyan bizonyítható a SEO és az AI optimalizálás megtérülése?

A legtöbb vállalkozó első kérdése: „Jó, jó, de hogyan mérem, hogy megéri-e a keresőoptimalizálás?”

A válasz egyszerű: a tartalom → lead riport megmutatja, mely oldalak hozzák a legtöbb ajánlatkérést, kapcsolatfelvételt vagy vásárlást.

Ez az egyik legerősebb riport, mert közvetlenül látszik:

– mely cikkeid konvertálnak,

– mely landing oldalak hoznak bevételt,

– milyen témákra érdemes új tartalmat építeni.

A SEO megtérülése nem vélemény kérdése, hanem adat.

És a legjobb adat: 6 hónapos időtáv.

A tartalmak ugyanis 3–6 hónap alatt érnek be, és egy jól megírt, AI-optimalizált tartalom akár évekig hoz ingyen ügyfelet.

Bővebben:

A keresőoptimalizálás és az AI válaszoptimalizálás megtérülését ma már sokkal pontosabban lehet mérni, mint néhány évvel ezelőtt. A vállalkozók többsége azért bizonytalan, mert nem látja át, hogyan kapcsolódnak össze a tartalmak, a kulcsszavak, a weboldal technikai teljesítménye és a beérkező ajánlatkérések száma. Éppen ezért kulcsfontosságú egy olyan riport, amely a teljes folyamatot átláthatóvá teszi: milyen tartalom milyen organikus forgalmat generál, és ebből mekkora arányban lesz valódi konverzió.

A tartalom → lead riport azért különösen értékes, mert nem csak azt mutatja meg, mekkora forgalmat hoz egy oldal, hanem azt is, hogy melyik tartalom termel pénzt. A jó keresőoptimalizálás egyik legfontosabb ismérve ugyanis nem a látogatók száma, hanem az értékes érdeklődők, ajánlatkérések, foglalások, megrendelések aránya. Ez alapján lehet eldönteni, mely kulcsszócsoportokba érdemes további tartalmat, új weboldal aloldalakat vagy akár kampányokat építeni.

A 6 hónapos időtáv azért ideális, mert a keresőmotorok és az AI algoritmusai ennyi idő alatt stabilizálják az új tartalmak helyét. Egy új blogcikk először feljebb mehet, majd visszaeshet, ezt követően találja meg a végleges pozícióját. A jó minőségű, jól strukturált, AI válaszoptimalizált tartalom pedig hónapok után is folyamatosan hozza a keresőből érkező ügyfeleket — teljesen ingyen.

Ráadásul az AI rendszerek (Google AI Mode, ChatGPT, Perplexity, Gemini) már nemcsak rangsorolnak, hanem hivatkoznak is a jól felépített tartalmakra. Így egyetlen alaposan megírt oldal egyszerre jelenhet meg a Google hagyományos keresőjében, az AI válaszdobozokban és a generált válaszok hivatkozásai között. Ez a fajta láthatóság sokkal nagyobb megtérülést hoz, mint bármely korábbi SEO-taktika — feltéve, hogy a weboldal technikailag rendben van, gyors, és jó minőségű weboldal tárhely szolgálja ki.

A SEO és az AI optimalizálás megtérülése tehát nem elmélet: pontosan mérhető, visszakereshető és hosszú távon stabil növekedést biztosít.

2. Weboldal migrációk – a legkritikusabb SEO hibák, amiket el kell kerülni

Amikor egy weboldalt új dizájnra, új tárhelyre vagy új domainre költöztetünk, az egyik legnagyobb hiba, amit látok: nem készül pre-migration benchmark.

A migráció előtt kötelező mérni:

– aktuális organikus forgalom,

– kulcsszópozíciók,

– indexelt oldalak száma,

– Core Web Vitals eredmények.

Benchmark nélkül nincs visszajelzés arról, hogy a migráció sikerült-e.

A másik gyakori hibakör:

2.1 Átirányítások hiánya vagy rossz használata

A régi URL → új URL térkép (URL mapping file) minden migráció alapja.

Elvek:

– Végleges változás = 301-es átirányítás

– Ideiglenes változás = 302-es átirányítás

– HTTP → HTTPS mindig 301

Téves hiedelem, hogy a 301-es átirányítás „elveszít linkértéket”. A valóság: átadja a linkérték csaknem 100%-át, és minimális rangsorvesztés történik csupán átmenetileg.

2.2 Árva oldalak kezelése

Ha van olyan régi oldal, amely az új weboldalon már nem létezik, de értékes forgalma van, akkor azt:

– a szülő kategóriaoldalra, vagy

– a témában legrelevánsabb oldalra

kell átirányítani.

Az árva oldalak hagyása 404-re óriási hiba.

2.3 Nagy weboldalak szakaszos migrációja

Ha több ezer URL-ről van szó, akkor a Google ajánlása szerint is előny:

– kisebb hibalehetőség

– gyorsabb ellenőrzés

– fokozatos indexelés

Nagy oldalt egyszerre migrálni komoly kockázat.

Bővebben:

Amikor egy nagy, több ezer vagy akár több tízezer URL-t tartalmazó weboldal migrációjáról beszélünk, a legfontosabb szempont a kontrollálhatóság. A Google már évekkel ezelőtt megfogalmazta a hivatalos ajánlását: a nagy volumenű weboldalakat szakaszosan érdemes költöztetni, nem pedig egyetlen nap alatt, teljes egészükben. Ennek elsődleges oka, hogy a keresőmotoroknak időre van szükségük az új struktúra feltérképezéséhez, megértéséhez és újraindexeléséhez. Ha mindez túl gyorsan és túl nagy mennyiségben történik, könnyen összeomolhat a rangsorolás, mert a Google nem tud lépést tartani az új URL-ek feldolgozásával.

A szakaszos migráció segít abban, hogy már az első hullámban is kiderüljön, van-e technikai probléma. Ha például az új szerveren nem megfelelő egy beállítás, hibás a weboldal tárhely konfiguráció, vagy rosszul működnek az átirányítások, akkor egy kisebb részletnél sokkal könnyebb korrigálni, mintha már több ezer URL esett volna ki az indexelésből. Ez komoly kockázat, hiszen a keresőoptimalizálás egyik legnagyobb ellensége a tömeges hibagenerálás és a hibásan felépített redirect-láncok.

A fokozatos költöztetés előnye az is, hogy a Google látja a stabilitást. Amikor kisebb URL-csoportok kerülnek át, az indexelés és a rangsorváltozás is egyenletesebb, kiszámíthatóbb. Ez segít abban, hogy a weboldal ne essen vissza hirtelen az organikus találatok között, ami különösen fontos olyan weboldalak esetében, amelyek nagy forgalmat bonyolítanak le vagy komoly bevételt termelnek.

Egy másik kritikus tényező az AI válaszoptimalizálás. A generatív keresőrendszerek folyamatosan tanulnak a weboldalak új struktúrájából, ezért különösen fontos, hogy az új URL-ek már az első pillanattól AI-kész formában legyenek felépítve: logikus felépítés, tiszta hierarchia, jól olvasható struktúra, metaadatok, kérdés–válasz blokkok. Ha a migráció során ezeket is figyelembe vesszük, az egész oldal sokkal erősebben teljesít az AI-alapú keresésben.

Összességében egy nagy weboldal szakaszos migrációja nemcsak ajánlott, hanem a professzionális keresőoptimalizálás egyik alapkövetelménye. Aki ezt figyelmen kívül hagyja, az feleslegesen kockáztat organikus forgalmat, bevételt és stabil pozíciót.

3. Technikai SEO – a professzionális weboldalépítés alapja

A keresőoptimalizálás ma nem csak tartalomról szól.

Egy weboldal technikai alapja dönti el, hogy a Google és az AI rendszerek egyáltalán megértik-e a tartalmadat.

Bővebben:

A keresőoptimalizálás ma már jóval túlmutat azon, hogy néhány kulcsszót elhelyezünk egy blogcikkben. A technikai SEO lett az a fundamentum, amelyre minden jól teljesítő weboldal épül. Hiába van kiváló tartalom, ha a weboldal technikailag gyenge, lassú, nehezen értelmezhető, vagy a szerver nem megfelelő teljesítményt nyújt. A Google és az AI rendszerek csak akkor tudják valóban feldolgozni és megérteni a tartalmat, ha a háttérben minden technikai elem összehangoltan működik.

Az egyik legfontosabb tényező a weboldal betöltési sebessége, amely nemcsak felhasználói élmény, hanem rangsorolási tényező is. A weboldal tárhely minősége, a szerver sebessége, a gyorsítótárazási megoldások, a PHP-konfiguráció és a képek optimalizálása mind közvetlenül hatnak a Core Web Vitals értékekre. Ezeket a Google külön pontozza, és ha egy weboldal gyenge LCP-t vagy magas CLS-t produkál, akkor automatikusan hátrébb kerül a találatok között.

A technikai SEO része továbbá a JavaScript működésének optimalizálása és az erőforrások megfelelő sorrendben történő betöltése. Az AI rendszerek különösen érzékenyek arra, hogy az oldal első másodperceiben mennyi hasznos információt kapnak. Ha a tartalom csak későn jelenik meg, vagy a script-függőségek blokkolják a renderelést, akkor az oldal nem fog jól teljesíteni sem a keresőmotorokban, sem az AI válaszoptimalizálás területén.

A technikai SEO tehát nem látványos, de kritikus: ez biztosítja, hogy a weboldal gyors, stabil és érthető legyen a Google és az AI rendszerek számára. Ha ez a rész rendben van, akkor minden további tartalmi és marketingmunka sokkal nagyobb hatékonysággal térül meg.

3.1 JavaScript megjelenítés

Ha a weboldal új tartalmat JavaScript segítségével tölt be, a keresőmotoroknak renderelniük kell azt.

A renderelés időigényes, így technikai szűk keresztmetszetet okozhat.

Megoldás:

– a kritikus JSet HTML-be építeni

– a nem létfontosságú kódot a láblécbe helyezni

Bővebben:

A modern weboldalak nagy része JavaScriptre támaszkodik, ami önmagában nem probléma, de ha a tartalom túlságosan a JS-re épül, az komoly technikai SEO kihívásokat okozhat. A Google és az AI rendszerek ugyan képesek renderelni a JavaScriptet, de a folyamat erőforrás-igényes, és nem garantált, hogy minden elem időben megjelenik az indexelés során.

Ezért gyakran előfordul, hogy egy fontos tartalom egyszerűen “későn töltődik be”, és a Google robotja nem veszi figyelembe a rangsorolásnál. Ugyanez történhet, ha az AI rendszerek nem tudják kivonni a releváns információkat a weboldalból, vagy a tartalom késleltetetten jelenik meg a DOM-ban.

Éppen ezért kiemelt fontosságú, hogy a kritikus tartalmak – például címek, első bekezdések, navigációs elemek, kulcsfontosságú szövegek – ne JavaScriptre legyenek bízva, hanem közvetlenül HTML-ben jelenjenek meg.

Ez gyorsabb renderelést, jobb indexelhetőséget és stabilabb keresőoptimalizálási teljesítményt eredményez. A nem létfontosságú elemeket – például animációkat, extra funkciókat, modális ablakokat vagy külső integrációkat – érdemes deferred vagy async módszerrel betölteni, esetleg a láblécbe helyezni, hogy ne blokkolják az oldal elsődleges renderelését.

Az AI válaszoptimalizálás szempontjából ez még kritikusabb. Ha az oldal kulcsüzenete JavaScript mögé rejtve érhető el, az AI modellek gyakran nem tudják megfelelően értelmezni. Így hiába jó a tartalom, a rendszer egyszerűen kihagyja a saját válaszaiból. Egy jól optimalizált weboldal tárhely és megfelelő JS-struktúra kombinációja biztosítja, hogy az oldal stabil, gyors és AI-barát legyen.

A JavaScript nem probléma – a rosszul felépített JavaScript viszont igen. Az optimalizálásával akár jelentős rangsorbeli előnyt lehet szerezni.

3.2 HTTP-kérések korlátozása

A weboldalak lassulásának egyik fő oka a túl sok HTTP kérés.

Fontos:

– CSS, JS fájlok összevonása

– Képek optimalizálása

– Sprite technika használata

A sprite-ok csökkentik a kérések számát, és növelik a vizuális konzisztenciát.

Bővebben:

A weboldal sebessége ma már nem csupán kényelmi tényező, hanem közvetlen rangsorolási és konverziós faktor. A Google és az AI rendszerek kifejezetten előnyben részesítik azokat az oldalakat, amelyek gyorsan, hatékonyan és felesleges terhelés nélkül töltődnek be.

Az egyik leggyakoribb probléma, amellyel a keresőoptimalizálás során találkozom, hogy a weboldal túl sok külön HTTP-kérést küld – gyakran teljesen feleslegesen. Minden egyes kép, CSS-fájl, JavaScript állomány, ikon vagy külső betöltés külön HTTP-kérés, ami lassítja a betöltést, és a Core Web Vitals értékeket is rontja.

A CSS és JS fájlok összevonása, tömörítése és minifikálása alapvető technikai SEO feladat. Ha egy weboldal tárhely és szerver infrastruktúra támogatja a modern optimalizálási technológiákat (HTTP/3, Brotli tömörítés, CDN, cache), akkor ezekkel drasztikusan csökkenthető a betöltési idő. Ezzel együtt a sprite technika továbbra is rendkívül hatékony megoldás olyan oldalaknál, ahol sok kis grafikai elem jelenik meg. Egy nagy sprite-fájl sokkal gyorsabban tölt be, mint 20–30 külön ikon, és sokkal stabilabb vizuális élményt ad, ami közvetlenül javítja a CLS értéket is.

A képek optimalizálása (WebP, AVIF, lazy loading, megfelelő méretek) szintén kulcsszerepet játszik a HTTP-kérések csökkentésében. Sok weboldalon találkozom azzal, hogy több megabájtos képek töltődnek be fölöslegesen, miközben egy jól tömörített WebP töredékére csökkentené a fájlméretet.

Az AI válaszoptimalizálás szempontjából mindez azért fontos, mert az AI modellek előnyben részesítik a gyorsan betöltődő oldalakat. Ha egy oldal túlterheli a böngészőt, vagy lassan jeleníti meg a tartalmat, az AI egyszerűen kihagyja a saját válaszaiból. A gyors betöltés tehát közvetlenül növeli annak esélyét, hogy a weboldalad bekerül az AI által generált eredmények közé.

A HTTP-kérések csökkentése tehát nem csupán technikai finomhangolás, hanem komoly teljesítménybeli előny — és döntő szerepet játszik mind a Google, mind az AI rendszerek szemében.

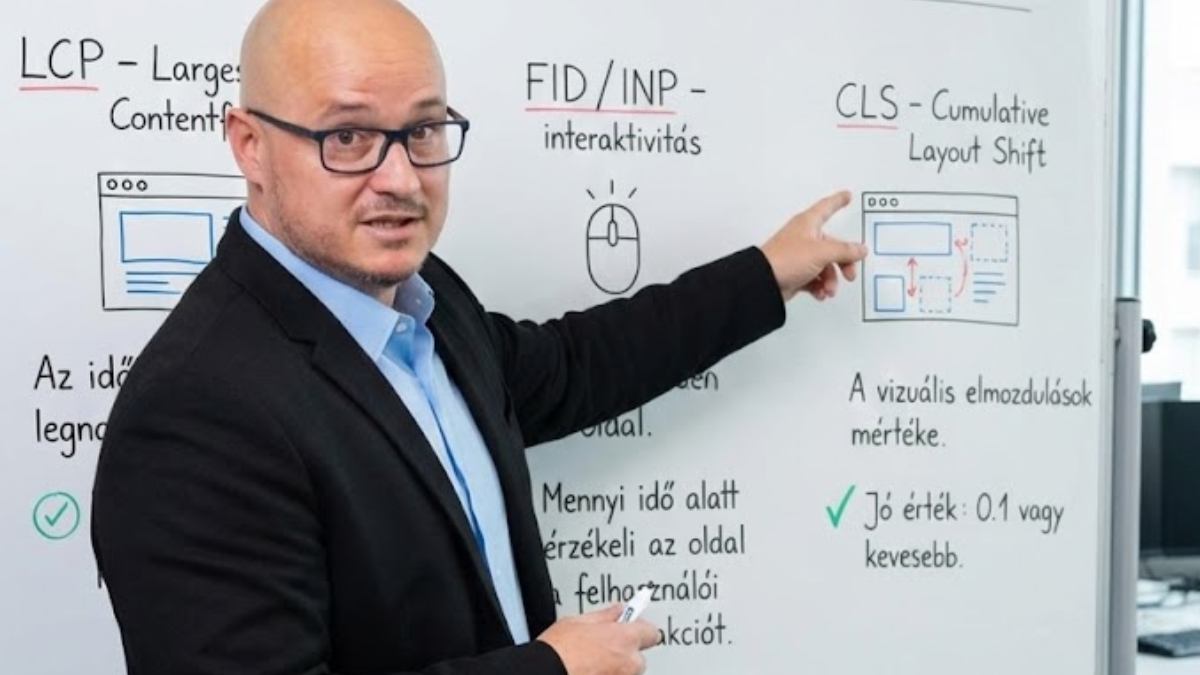

3.3 Core Web Vitals – a teljesítmény három kulcsa

LCP – Largest Contentful Paint

Az idő, amíg a legnagyobb tartalmi elem megjelenik.FID / INP – interaktivitás

Mennyi idő alatt érzékeli az oldal a felhasználói interakciót.CLS – Cumulative Layout Shift

A vizuális elmozdulások mértéke.

Jó érték: 0.1 vagy kevesebb.

Az inline kép-méretek például javítják a CLS-t, mert megakadályozzák az elmozdulást.

Bővebben:

A Core Web Vitals ma már a keresőoptimalizálás egyik legmeghatározóbb eleme. A Google és az AI rendszerek számára a sebesség, a stabilitás és a felhasználói élmény olyan mértékben vált elsődlegessé, hogy sok esetben még a jó tartalmat is hátrébb sorolhatják, ha a technikai minőség nem megfelelő.

Ezen mutatók pontos mérése ráadásul nem csak rangsorolási kérdés: közvetlen hatással van a konverziókra, a felhasználók elégedettségére, és arra is, hogy az AI rendszerek milyen mértékben tudják feldolgozni és felhasználni a weboldal tartalmát.

Az LCP (Largest Contentful Paint) azt mutatja meg, mennyi idő alatt jelenik meg az oldal fő tartalmi eleme. Ha ez túl lassú, a felhasználó kilép, az AI pedig kevésbé bízik az oldal minőségében. A gyors LCP elsősorban egy jó weboldal tárhelyen, optimalizált képekkel, reszponzív dizájnnal és gyors szerveroldali feldolgozással érhető el.

Az INP (Interaction to Next Paint) – amely mára gyakorlatilag felváltotta a régi FID mutatót – azt méri, mennyire gyorsan reagál az oldal egy kattintásra, form kitöltésére vagy bármilyen interakcióra. Ha egy weboldal túl sok JavaScriptet tölt be, vagy a háttérben futó kódok blokkolják a válaszidőt, az INP romlani fog. Ez nemcsak a felhasználók élményét rontja, hanem az AI válaszoptimalizálás eredményét is, hiszen az AI modellek előnyben részesítik a gyorsan és kiszámíthatóan működő oldalakat.

A CLS (Cumulative Layout Shift) pedig a vizuális stabilitást méri. Ha az oldal elemei ugrálnak, betöltés közben elmozdulnak, vagy a reklámok “össze-vissza tolják” a tartalmat, az nemcsak rossz UX, de komoly SEO hibának is számít. Az inline kép-méretek megadása, a stabil konténerek használata és a betűtípus-optimalizálás mind javítja a CLS-t.

A Core Web Vitals optimalizálása tehát nem technikai apróság, hanem a modern keresőoptimalizálás egyik alapfeltétele. Ez az a rész, ahol a jól felépített technikai háttér és a minőségi weboldal tárhely együtt dönti el, mennyire lesz sikeres a weboldal a Google-ben és az AI rendszerek válaszaiban is.

3.4 Gyorsítótárazás

Két kulcsfogalom:

– Browser caching – a böngésző tárolja a fájlokat

– Server-side caching – a szerver menti a renderelés eredményét

A gyorsítótárazás a weboldal sebességének egyik legerősebb faktorává vált.

Bővebben:

A gyorsítótárazás a modern weboldalak teljesítményének egyik legfontosabb eleme, és kulcsfontosságú tényező a keresőoptimalizálás és az AI válaszoptimalizálás szempontjából is.

A Google kifejezetten előnyben részesíti azokat a weboldalakat, amelyek gyorsan és hatékonyan szolgálják ki az első és az ismételt látogatásokat egyaránt. A gyorsítótárazás lényege, hogy a böngészőnek vagy a szervernek ne kelljen minden alkalommal újra legenerálnia az oldal erőforrásait – képeket, CSS-t, JavaScriptet, HTML-t vagy akár dinamikus komponenseket.

A böngésző oldali cache (browser caching) lehetővé teszi, hogy a felhasználó gépe helyileg tárolja azokat a fájlokat, amelyek ritkán változnak. Így második látogatáskor már nem kell minden egyes képet vagy stíluslapot újra lekérni a szervertől. Ez jelentősen csökkenti a HTTP-kérések számát, gyorsítja az oldal betöltését, és különösen fontos, ha a weboldal nagy forgalmat kezel. Ez az élmény az AI rendszerek számára is pozitív jelzés: a gyors oldal stabil, megbízható, jól felépített.

A szerveroldali gyorsítótárazás (server-side caching) ennél is erősebb teljesítménynövekedést biztosít. Ilyenkor a weboldal tárhely és a szerver egyszer már feldolgozott oldalverziókat tárol, és újra kéréskor nem kell minden elemet PHP-ből vagy adatbázisból generálni.

Ez különösen fontos WordPress oldalaknál, ahol a dinamikus tartalom miatt sok időt vesz igénybe a teljes oldal újragenerálása. Egy jól beállított szerveroldali cache akár tízszeres gyorsulást is eredményezhet.

SEO szempontból ez óriási előny: a gyors oldal alacsonyabb visszafordulási arányt eredményez, jobbak lesznek a Core Web Vitals értékek, stabilabb lesz az indexelés, és kevesebb lesz a renderelési hiba. AI válaszoptimalizálás szempontjából pedig döntő tényező, mert az AI modellek előnyben részesítik a gyorsan betöltődő, stabil, technikailag hibátlan oldalakat a saját válaszaik hivatkozásaiként.

A gyorsítótárazás tehát nem csupán egy technikai finomhangolás: ez az alapja annak, hogy egy weboldal professzionális, gyors és keresőmotor-barát legyen. Ha ez rendben van, minden egyéb SEO és AI-optimalizálási munka sokkal nagyobb hatékonysággal térül meg.

4. Weboldal tárhely – miért múlik ezen minden?

A weboldal tárhelye minősége közvetlenül befolyásolja:

– a keresőoptimalizálást,

– a Core Web Vitals értékeket,

– a feltérképezési keretet (crawl budget),

– és az AI rendszerek tartalomfelismerését.

Ha a szerver lassú, túlterhelt, vagy rosszul konfigurált, akkor hiába a jó tartalom, a weboldal soha nem fogja azt a teljesítményt hozni, amire képes.

A jó tárhely:

– gyors CPU-val rendelkezik

– SSD/NVMe alapú

– optimalizálható (PHP, memória, cache)

– stabil

– HTTP/3-al kompatibilis

– rendelkezik botvédelmi megoldásokkal

A weboldal tárhely sokszor az a pont, ahol egy vállalkozás először spórolna – pedig technikai szempontból ez döntő fontosságú.

Bővebben:

A weboldal tárhely minősége az egyik leginkább alábecsült tényező a keresőoptimalizálásban. Sok vállalkozó úgy gondolja, hogy „a tárhely az csak egy hely, ahol a weboldal lakik” – pedig valójában ez az alapja mindennek. Egy gyors, stabil, modern szerver akár 20–40%-kal is javíthatja a Core Web Vitals értékeket, amelyek már közvetlen rangsorolási tényezők. Ha a weboldal lassan reagál, nagy a várakozási idő, akadozik a PHP-feldolgozás, vagy túlterhelődik a szerver, akkor ezt a Google is érzékeli, és hátrébb sorolja az oldalt.

SEO szempontból a jó tárhely azt jelenti, hogy az oldal gyorsan kiszolgálható, nem keletkeznek HTTP 5xx hibák, nem fagy le a szerver terhelés alatt, és a keresőrobotok akadálytalanul tudják feltérképezni az oldal minden URL-jét. Ha a crawl budget fele arra megy el, hogy a szerver lassú válaszideje miatt a Google botja várakozik, akkor kevesebb tartalom kerül indexelésre, ami közvetlen organikus visszaesést okoz. A feltérképezési keret optimalizálásához tehát elengedhetetlen a gyors szerveroldali válaszadás.

AI válaszoptimalizálás szempontjából a tárhely szerepe még kritikusabb. Az AI rendszerek a gyorsan betöltődő, stabil, hibamentes weboldalakat részesítik előnyben, amikor kiválasztják, mely oldalakat idézik vagy használnak fel a válaszaikban. Ha a weboldal lassú, vagy a szerver egyszer-egyszer hibát ad, az AI rendszer „megbízhatatlannak” minősíti, és nem hivatkozik rá – még akkor sem, ha amúgy kiváló tartalom található rajta.

A jó weboldal tárhely tehát nem luxus, hanem stratégiai befektetés. Egy NVMe SSD-s, modern HTTP/3 kompatibilis, stabil infrastruktúra gyorsabb oldalbetöltést, jobb felhasználói élményt és jelentősen erősebb SEO teljesítményt biztosít. A vállalkozások gyakran ott próbálnak spórolni, ahol a legnagyobb kárt okozzák maguknak: a tárhelyen. Valójában ez a legfontosabb technikai alap, ami meghatározza, hogy a keresőoptimalizálás és az AI optimalizálás mennyire tudja kihozni a maximumot a weboldalból.

5. Kulcsszóstratégia és versenytárs-elemzés

A valódi keresőoptimalizálás ott kezdődik, hogy feltérképezem:

– mire keresnek a célügyfelek,

– mire rangsorolnak a versenytársak,

– hol vannak a kulcsszóhézagok.

Bővebben:

A keresőoptimalizálás alapja mindig a kulcsszóstratégia. A legtöbb weboldal azért nem hoz stabil organikus forgalmat, mert nem a valós keresési szándékra, hanem véletlenszerűen kiválasztott kifejezésekre épít.

A hatékony kulcsszóstratégia első lépése annak megértése, hogy mire keresnek a célügyfelek, milyen problémákat próbálnak megoldani, milyen kérdéseket tesznek fel, és milyen tartalomtípusokra reagálnak leginkább. Ezért minden esetben részletes keresési szándék-elemzéssel indulok, mert a Google és az AI rendszerek is ezt figyelik: tartalmaz-e a weboldal választ a felhasználó valós kérdésére.

A versenytársak vizsgálata ugyanilyen fontos. SEO szempontból nem azok a versenytársak az igazi ellenfelek, akikkel üzleti szinten vetélkedsz, hanem azok, akik ugyanazokra a kulcsszavakra jelennek meg a keresőben. Éppen ezért elemzem, hogy kik rangsorolnak jól a legfontosabb kifejezésekre, milyen tartalomszerkezettel, milyen technikai megoldásokkal és milyen backlink háttérrel dolgoznak. Ez adja azt a térképet, amelyből egyértelműen kirajzolódnak az előnyök és a hiányosságok.

A kulcsszóhézagok (keyword gaps) jelentik a leggyorsabb növekedési lehetőséget. Ezek azok a kifejezések, amelyekre a versenytársak már rangsorolnak, te viszont egyáltalán nem vagy jelen — vagy csak gyengén. Ilyenkor már a minimálisan jól megírt tartalom is komoly előrelépést hozhat, de ha a tartalom AI válaszoptimalizálás szempontból is jól van strukturálva (kérdés-válasz logika, magyarázó jelleg, példák, alcímek), akkor sokkal gyorsabban tud bekerülni az AI rendszerek által generált válaszokba is.

A kulcsszóstratégia tehát nem egyszeri feladat, hanem folyamatos elemzés és finomhangolás. A Google frissítések, a versenytársak mozgása, a szezonális keresések és az új AI trendek folyamatosan alakítják, ezért rendszeresen újraoptimalizálom, hogy a weboldal hosszú távon is erős pozícióban maradjon.

5.1 Kulcsszóhézagok (keyword gaps)

Olyan kifejezések, amelyekre:

– a versenytársak jó pozícióban vannak,

– te pedig egyáltalán nem vagy jelen.

Innen lehet a leggyorsabban forgalmat szerezni.

5.2 Miért nem azonosak az üzleti és a SEO versenytársak?

Sokan meglepődnek, amikor megmutatom:

– üzletileg másokkal versenyeznek,

– de a Google-ben teljesen más cégek vannak mellettük.

SEO szempontból azok a versenytársak, akik ugyanazokra a kulcsszavakra jelennek meg, mint te.

5.3 SEO versenytárs-elemzés céljai

Egy profi elemzés során az alábbiakat vizsgálom:

– mely tartalmak hozzák a legtöbb organikus forgalmat

– milyen backlinkprofiljuk van

– milyen technikai megoldásokat használnak

– hol vannak gyenge pontjaik

– mennyire AI-optimalizált a tartalmuk

Ezek alapján építem fel azt az online marketing stratégiát, amellyel meg lehet előzni őket.

6. Tartalomstratégia, amelyet a Google és az AI is szeret

2025-ben egy modern tartalomstratégia már nem szólhat kizárólag a Google-ről.

Az AI-alapú keresés ugyanis más logikát követ:

– kérdés–válasz alapú,

– narratív összefüggéseket keres,

– kontextust vizsgál,

– nemcsak kulcsszavakat figyel.

Ez a különbség.

A Google rangsort állít össze.

Az AI választ generál.

A tartalomnak mindkét rendszer számára:

– érthető

– strukturált

– magyarázó

– tényszerű

– kontextusban gazdag

kell lennie.

6.1 Latens kérdések és AI-kész tartalmak

AI szempontból kulcsfontosságú:

– H1–H3 logikus hierarchia

– alcímekben megfogalmazott kérdések

– definíciók pontos megadása

– szinonimák és variációk használata

– magyarázó jellegű szöveg

– egyértelmű összefüggések

A legtöbb weboldal itt veszíti el a lehetőséget: nem adja meg a kontextust.

7. On-page és Off-page SEO – a teljes ökoszisztéma

A modern keresőoptimalizálás 4 pilléren áll:

- Technikai SEO

- Tartalomoptimalizálás

- On-page SEO

- Off-page SEO

Mindegyikre szükség van ahhoz, hogy a weboldal stabilan teljesítsen.

Bővebben:

A modern keresőoptimalizálás már nem arról szól, hogy egyetlen területet optimalizálunk, hanem egy komplett ökoszisztéma összehangolt működéséről. A négy fő pillér – technikai SEO, tartalomoptimalizálás, on-page SEO, off-page SEO – együtt adja azt az erőt, amely meghatározza, hogy egy weboldal mennyire tud stabil, növekvő organikus forgalmat generálni.

A vállalkozások többsége ott hibázik, hogy csak egyetlen pillérre koncentrál, például írnak néhány blogcikket, de közben a technikai háttér vagy a linkprofil teljesen fejletlen. Ilyenkor a weboldal nem tudja kiaknázni a benne rejlő potenciált.

A technikai SEO biztosítja azt a fundamentumot, hogy a Google és az AI rendszerek egyáltalán tudják értelmezni a weboldal tartalmát. A gyors szerver, jó weboldal tárhely, tiszta HTML, optimalizált JS és stabil Core Web Vitals nélkül minden más erőfeszítés csak félkarú próbálkozás.

Ezután jön a tartalomoptimalizálás, ahol a hangsúly az értékes, magyarázó, AI-barát tartalmakon van. Ma már nem elég kulcsszavakat ismételgetni: a tartalmaknak válaszolniuk kell a felhasználók kérdéseire, és olyan összefüggéseket kell tartalmazniuk, amelyeket az AI modellek könnyen értelmeznek.

Az on-page SEO feladata, hogy a tartalom technikailag is jól „be legyen csomagolva”: meta címek, struktúrált adatok, logikus heading-hierarchia, belső linkháló, megfelelő URL-struktúra. Ezek nélkül a Google nem látja át az oldal felépítését, és nem tudja megfelelően rangsorolni.

Az off-page SEO – vagyis a linkprofil és a külső említések – adja meg azt az autoritást, amelyre minden weboldalnak szüksége van. A minőségi backlinkek növelik a hitelességet, és ráerősítenek az AI válaszoptimalizálásra is, mert az AI rendszerek a hitelesebb forrásokra építik fel a válaszaikat.

A SEO csak akkor működik, ha mind a négy pillér stabil. Ha bármelyik hiányzik, a teljes ökoszisztéma gyengül, és a weboldal nem tudja elérni a kívánt eredményeket.

7.1 On-page SEO

Ide tartozik:

– kulcsszóhasználat

– meta title, meta description

– URL-struktúra

– belső linkháló

– heading hierarchia

– schema.org strukturált adatok

– képek alt text optimalizálása

7.2 Off-page SEO

A legfontosabb eleme a backlink profil.

Nem a mennyiség, hanem a minőség számít.

Egy jó stratégia:

– olyan oldalakat keres, amelyek már hivatkoznak a versenytársadra

– és ezeken a felületeken kér linket a te weboldaladra is

Ez a megközelítés sokkal gyorsabban hoz eredményt, mint a vak linképítés.

8. Miért fontos követni az algoritmus-frissítéseket?

A Google frissítései közvetlenül hatnak:

– a rangsorra,

– a forgalomra,

– a tartalmak teljesítményére.

Ha egy frissítés után hirtelen visszaesik a forgalom, mindig megmutatom az ügyfeleimnek:

– az oldaluk mely része érintett,

– mi volt a frissítés fókusza,

– és hogyan lehet alkalmazkodni hozzá.

Az algoritmus-frissítések követése nem opció – kötelező.

9. Crawl budget – hogyan ne pazarolja el a weboldal?

A feltérképezési keret véges.

Ezért kerülendő:

– duplikált tartalom

– hosszú átirányítási lánc

– végtelen oldalgenerálás

Minél több felesleges oldalt tölt be a Google robot, annál kevesebb energiája jut a valóban fontos tartalmakra.

10. A felhasználói élmény és a SEO kapcsolata

A Core Web Vitals mérései alapján a Google egyértelművé tette:

A jó UX = jó SEO.

A villódzó betűtípusok, elmozduló elemek, lassan betöltődő képek, rossz tárhely és erőforrásigényes JS kódok mind rontják az eredményt.

A profi megoldás:

– max. 1–2 egyedi betűtípus

– inline méretezés

– optimalizált képek

– tömörített CSS/JS

– gyors cache

– modern tárhely

11. Pogo-sticking – a veszélyes SEO jelenség

A pogo-sticking akkor történik, amikor a felhasználó:

– visszalép a keresőre,

– másik találatra kattint,

– majd újra visszalép.

Ez azt jelzi: az oldal nem adott választ a kérdésére.

Az AI rendszerek ezt sokkal szigorúbban figyelik, mint eddig.

12. Pénzügyi megtérülés, mérés, riportok

A legfontosabb mérések:

– Search Console: kattintások, megjelenítések, CTR

– Analytics: konverziók, bounce rate, idő az oldalon

– Tartalom → lead riport

– 6 hónapos trend összevetések

A SEO nem gyors eredmény, de nagyon stabil, kiszámítható és hosszú távon a legköltséghatékonyabb ügyfélszerző csatorna.

13. Felhasználóbarát pop-up használat

A pop-up legyen:

– mobilbarát

– ésszerű méretű

– ne blokkoljon kulcstartalmat

– ne legyen agresszív

A keresőoptimalizálás ma már figyeli a használhatóságot is.

Záró gondolatok: miért fontos, hogy legyen profi SEO és AI-optimalizálás a weboldal mögött?

Mert a weboldal ma már nem csak „egy online névjegykártya”.

A weboldal:

– az első benyomás

– az értékesítés központja

– a márka reputációjának alapja

– az AI rendszerek első információforrása

Aki ma nem kezeli komolyan:

– a technikai SEO-t,

– az AI válaszoptimalizálást,

– a tartalomstratégiát,

– a weboldal tárhely minőségét,

– a migrációk szakszerű lebonyolítását,

– a Core Web Vitals eredményeit,

az gyorsan hátrányba kerül.

A modern keresőoptimalizálás ma már nem csupán egy marketingtevékenység, hanem a vállalkozás növekedésének motorja.

Miért nélkülözhetetlen ma egy szakértő, és miért dolgozom napi rendszerességgel?

A keresőoptimalizálás és az AI válaszoptimalizálás ma már nem egy kampány, nem egy féléves projekt és nem egy egyszer beállított technikai lista kipipálása. A Google, a mesterséges intelligencia és az online fogyasztói viselkedés olyan gyorsan változik, hogy aki havonta vagy negyedévente akar optimalizálni, az egyszerűen lemarad.

A siker ma már nem a „jó helyezésekről” szól, hanem arról, hogyan reagálunk napról napra a frissítésekre, hogyan fejlesztjük a tartalmakat, hogyan javítjuk a technikai hibákat és hogyan tesszük érthetővé a weboldalt az AI rendszerek számára.

Ezért dolgozom én napi rendszerességgel

Mert a weboldal nem egy statikus eszköz – egy élő rendszer, amely folyamatos karbantartást, finomhangolást, elemzést és fejlesztést igényel. Ahogy a Google frissít, ahogy megjelennek új AI keresési logikák, ahogy változnak a felhasználói igények, úgy kell a weboldaladon is módosítani mindazt, ami befolyásolja a találati pozíciókat és a konverziókat. A napi munkámmal biztosítom, hogy ne csak lépést tarts a változásokkal, hanem előnyre tegyél szert.

Nélkülözhetetlen vagyok, mert egy átlagos vállalkozó nem tudja követni a keresőoptimalizálás és az AI fejlődésének tempóját. Ez már nem arról szól, hogy „legyen gyors a weboldal” vagy „írjunk egy blogcikket”.

Ma már figyelni kell az algoritmusfrissítéseket, a szerversebességet, a Core Web Vitals értékeket, a kulcsszótrendeket, az AI válaszmezők működését, az új kérdés-válasz logikákat, a konkurencia mozgását, a struktúrált adatokat, a tartalmak AI-értelmezhetőségét, az oldalon belüli UX-et és még számos olyan apróságot, amely együttesen eldönti, hogy egy weboldal látható vagy láthatatlan marad.

-Az én feladatom az, hogy minden nap figyeljem és irányítsam ezt az egész ökoszisztémát – helyetted.

-Hogy a weboldalad mindig a keresőmotorok és az AI rendszerek élvonalában legyen.

-Hogy te ne csak jelen legyél online, hanem domináld a saját piaci szegmensedet.

A mai online környezetben nem az nyer, aki elindít valamit. Hanem az, aki folyamatosan optimalizál, fejleszt és alkalmazkodik.

Ezért van szükség napokra lebontott szakértői munkára. És ezért nélkülözhetetlen egy olyan szakember, aki érti is, mi történik a háttérben – nem csak technikai, hanem stratégiai szinten is.